KI-Desinformation auf TikTok: Angriffe zielen auf die Bundesregierung

Mit Hilfe von KI können politische wie kommerzielle Desinformationsakteure massenhaft Inhalte produzieren. Tausende TikTok-Videos auf Deutsch greifen seit Monaten die Bundesregierung und den Bundeskanzler Merz an. Die Plattform muss konsequenter gegen KI-gestützte Desinformation vorgehen.

Die Entwicklung der generativen KI führt zu einer zunehmenden Präsenz der synthetischen Inhalte in den Social-Media-Feeds der Nutzer:innen weltweit. Laut einer Untersuchung von AI Forensics enthalten ein Viertel der Top-Suchergebnisse auf TikTok KI-generierte Bilder. KI ermöglicht eine schnelle und billige Produktion der Inhalte, die Social-Media-Plattformen überfluten und häufig viral gehen – unterstützt von Empfehlungsalgorithmen. Dank der KI-gestützten massenhaften Produktion können die Produzent:innen der Social-Media-Inhalte unterschiedliche Strategien der Verbreitung ausprobieren, um festzustellen, welche Inhalte von Empfehlungsalgorithmen priorisiert werden.

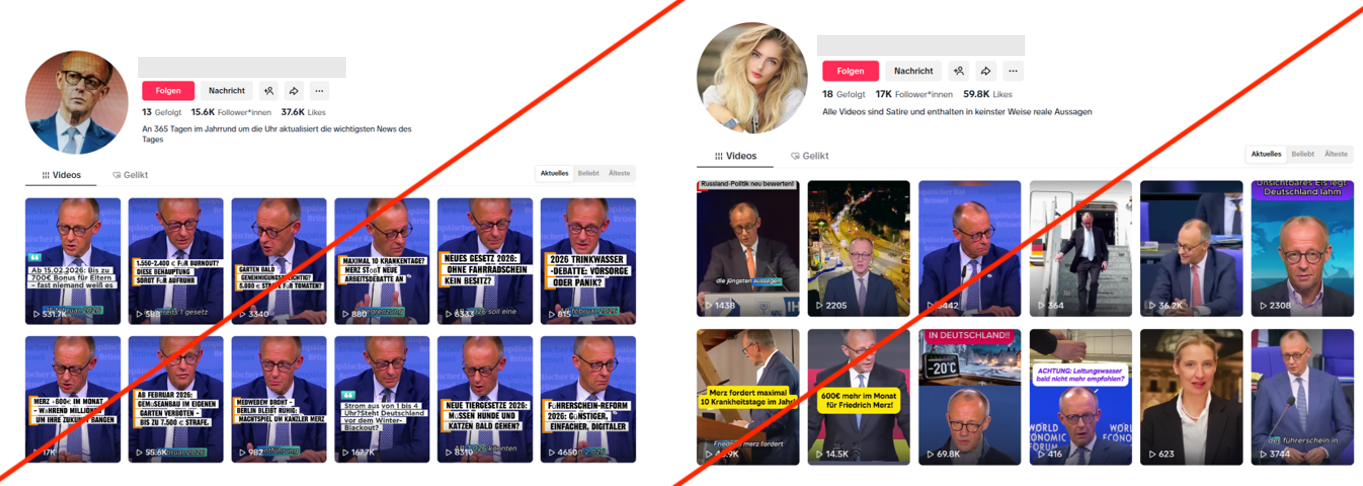

Die Social-Media-Plattformen ermöglichen die Verbreitung solcher KI-generierten Inhalte von niedriger Qualität, die als „KI-Slop“ bekannt sind, und können sie mit ihren Monetarisierunsregeln sogar begünstigen. TikTok hat beispielsweise das „Creator Rewards Program“, das Accounts mit über 10.000 Follower:innen und über 100.000 Video-Views in den letzten 30 Tagen in bestimmten Ländern für monetäre Ausschüttungen qualifiziert. Das führt zu der Verbreitung von sogenannten „Content Farms“, die massenhaft KI-gestützte Video-Inhalte für TikTok produzieren. Diese Videos werden häufig nach bestimmten Mustern erstellt und greifen nachrichtliche oder emotionale Themen auf, die das Potenzial haben, mit großer Wahrscheinlichkeit viral zu gehen.

„KI-Slop“ ist mitnichten ein unpolitisches Phänomen: Videos der „Content Farms“ enthalten Falschinformationen über Politiker:innen, Regierungen und politisch relevante Sachverhalte. In diesem Blogbeitrag beleuchten wir das am Beispiel der TikTok-Videos, die die Bundesregierung mit Falschinformationen über angebliche absurde neue Regelungen diskreditieren. Videos in diesem Format werden nicht nur in Deutschland verbreitet: In Großbritannien wird der Premierminister Keir Starmer laut einer Recherche von NewsGuard mit Tausenden ähnlichen Fake-Videos auf TikTok angegriffen.

Für Deutschland konnte CeMAS mindestens 72 TikTok-Accounts identifizieren, die KI-gestützte Desinformation über deutsche Politik und Gesetzesvorhaben verbreiten. Die manuell recherchierten und überprüften Accounts erreichen zusammen rund 1,1 Millionen Follower:innen. Bereits die jeweils meistgesehenen Videos (ein Video pro Account als Berechnungsgrundlage) wurden insgesamt rund 38 Millionen Mal abgespielt (Stand 27.01.2026). Insgesamt veröffentlichten diese Accounts im Zeitraum zwischen dem 15.11.2024 und dem 27.01.2026 mindestens 5.265 Videos, die 162 Millionen Mal Views, 2,7 Millionen Likes sowie rund 386.000 Kommentare erhalten haben. Es ist davon auszugehen, dass diese Accounts nur einen Teil eines größeren, ähnlichen Netzwerks oder mehrerer Netzwerke auf der Plattform abbilden.

Inhaltlich verbreiten die Accounts wiederkehrend Falschbehauptungen über angeblich neu eingeführte Regelungen in der Bundesrepublik sowie verzerrende Beiträge zu aktuellen Ereignissen. Die Bundesregierung und insbesondere der Bundeskanzler werden dabei systematisch negativ dargestellt. Gleichzeitig werden AfD-freundliche und pro-russische Narrative gestreut, was auf eine politische Zielsetzung über reinen Clickbait hinaus hindeutet. Auffällige Fehler in KI-generierten Vertonungen und Untertiteln deuten auf ausländische Urheber:innen oder nicht-deutschsprachige Produktionsprozesse hin. Plausibel ist daher, dass die Accounts von politischen und/oder kommerziellen Desinformationsakteuren betrieben werden.

Analysierte Inhalte

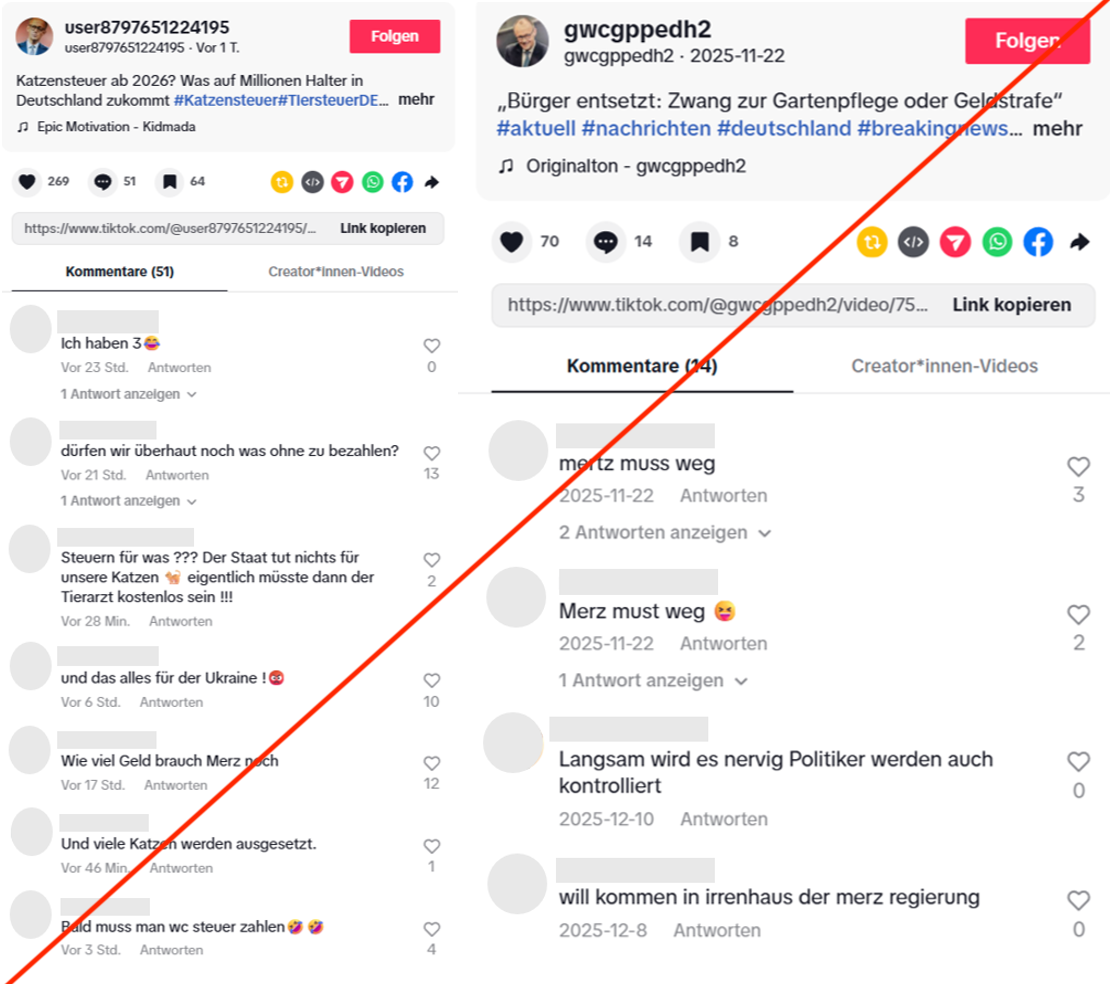

Thematisch zielen die Inhalte auf alltagsnahe Bereiche wie Schule, Haustiere, Rente, Verkehr oder Steuern ab. Sie behaupten, dass angeblich Verbote und Regulierungen eingeführt werden sollen, die das Leben spürbar erschweren würden (etwa neue Abgaben auf Hunde und Katzen, Verbot privater Gärten, Staubsaugverbot am Wochenende, private Zahlungspflichten für Rettungseinsätze). Ein Teil der Videos bedient zudem das Narrativ einer „Islamisierung“ Deutschlands, etwa durch erfundene Vorgaben zu Halal-Angeboten im Einzelhandel, angeblich legalisierte Polygamie oder einen erfundenen neuen Schnellzug, der Istanbul und Berlin in einer Stunde verbinden soll.

Die angeblichen neuen Regelungen werden als Entscheidungen der Bundesregierung oder als persönliche Anordnungen des Bundeskanzlers ohne öffentliche Debatte inszeniert. Viele Videos stellen Friedrich Merz in den Mittelpunkt. Sein Bild wird wiederkehrend in den Videosund als Vorschaubild genutzt. Es soll der Eindruck entstehen, die Bundesregierung handle gegen die Interessen der Bürger:innen und erschwere gezielt den Alltag.

Die Accounts beziehen sich zudem auf aktuelle Ereignisse mit hoher Aufmerksamkeit (etwa ein vermisstes Kind, Stromausfall in Berlin). Ein Teil dieser Inhalte dient erkennbar der Reichweitensteigerung. Andere Beiträge verknüpfen Ereignisse mit politischen Aus-sagen und Falschbehauptungen. Nach dem Berliner Stromausfall wurden etwa Videos verbreitet, die eine Verteilung von Mahlzeiten durch die AfD und ein angebliches staatliches Verbot dieser Hilfe behaupten. Weitere Videos stellen AfD-Vorhaben verkürzt dar oder verbreiten unbelegte Behauptungen über Treffen der AfD-Vorsitzenden Alice Weidel mit der italienischen Premierministerin Giorgia Meloni. Insgesamt wird die AfD wiederholt in einem positiven Licht dargestellt, während die Bundesregierung als wenig bürgernah beschrieben wird.

Ein weiterer Teil der Videos enthält pro-russische Narrative, wie etwa die Abwertung der ukrainischen Geflüchteten, Kritik an der Unterstützung der Ukraine und der Ukraine-Politik der Bundesregierung sowie die Darstellung der Ukraine als Hindernis in den Friedensgesprächen.

Taktiken und Verhalten

In Video- und Accountbeschreibungen finden sich häufig Hinweise auf angebliche „Satire“. Dies kann als Versuch gewertet werden, Moderationsmaßnahmen zu umgehen. Inhaltlich handelt es sich jedoch überwiegend um politische Falschinformationen, die auf die Diskreditierung der Bundesregierung abzielen. Die Beiträge weisen insgesamt eine geringe inhaltliche und visuelle Qualität auf, wie sie für „KI-Slop“ typisch ist. Verwendet werden sowohl Ausschnitte aus öffentlich zugänglichem Material als auch KI-generierte Bilder von Politiker:innen. Teilweise kommen KI-generierte Moderator:innen, Deepfakes oder synthetische Darstellungen von Influencer:innen bzw. Medienschaffenden zum Einsatz. Zur Reichweitensteigerung werden zudem hochfrequentierte Hashtags genutzt.

Kommentare

Eine stichprobenartige Sichtung der Kommentare ergab, dass eine Vielzahl der Kommentare trotz der schlechten Qualität der Videos so klingt, als würden die Verfasser:innen die Informationen ernst nehmen und entweder die Bundesregierung dafür kritisieren oder die AfD glorifizieren. Zahlreiche Kommentare fordern den Rücktritt des Bundeskanzlers oder behaupten – auch unter den Videos, die thematisch nichts mit Russland oder der Ukraine zu tun haben – dass die Regierung zu viel Geld für die Ukraine ausgebe. Eine systematische und umfassende Auswertung der Kommentare war wegen eines fehlenden Datenzugangs nicht möglich. Merkmale wie fehlende Zusammenhänge zwischen den Videos und den Kommentaren sowie häufige grammatikalische Fehler sprechen jedoch dafür, dass die Plattform auch die Kommentare auf weitere Hinweise der koordinierten, nicht-authentischen Aktivität überprüfen sollte.

Hinweise auf Urheberschaft

Mehrere Indikatoren, wie identische Falschbehauptungen auf mehreren Accounts, wiederverwendete Videosequenzen, gegenseitiges Folgen sowie zeitlich eng beieinanderliegende Registrierungen (teils im Abstand von 1–2 Minuten) sprechen dafür, dass die Accounts mit hoher Wahrscheinlichkeit Teil eines koordinierten Netzwerks oder mehrerer Netzwerke sind. Zudem enthalten die KI-Vertonungen und Untertitel zahlreiche sprachliche Fehler, was auf eine nicht-deutsche Urheberschaft hindeutet. Ein Account veröffentlichte zunächst zwei Videos mit russischer Tonspur und deutsch-russischen Untertiteln, bevor er auf deutschsprachige Inhalte umstellte. Zusammen mit pro-russischen Narrativen in mehreren Videos ist dies ein möglicher Hinweis auf pro-russische Urheberschaft. Eine belastbare eindeutige Zuordnung war jedoch zum jetzigen Zeitpunkt noch nicht möglich.

Denkbar ist, dass hinter den Accounts kommerzielle Betreiber:innen stehen, die das TikTok-Monetarisierunsprogramm nutzen. Außerdem ist es möglich, dass politische Desinformationsakteure Dienstleistungen oder die Account-Infrastruktur der kommerziellen „Content Farms“ in Anspruch nehmen, um massenhaft Desinformation zu verbreiten.

Plattformen müssen konsequenter gegen KI-gestützte Desinformation vorgehen

Generative KI erleichtert es politischen und kommerziellen Akteur:innen, irreführende Inhalte in großer Menge zu produzieren und zu verbreiten. Eine rein fallbezogene Moderation (Melden einzelner Beiträge oder Accounts) ist bei den hier beobachteten Mustern nicht ausreichend. Erst die systematische Analyse über mehrere Accounts hinweg macht den politischen Charakter und die Koordination erkennbar. Plattformen sollten daher verpflichtet werden, Netzwerkstrukturen und Interaktionsmuster auszuwerten und diese Daten in geeigneter Form für Forschung und Zivilgesellschaft zugänglich zu machen, um koordiniertes, unauthentisches Verhalten auf ihren Plattformen identifizierbar zu machen. Die hier gezeigte massenhafte Verbreitung von KI-generierten Low-Quality-Inhalten („KI-Slop“) kann als Instrument zur Beeinflussung und Destabilisierung öffentlicher Debatten genutzt werden und ist entsprechend als Risikofaktor zu behandeln. Mit dem Digital Services Act (DSA) werden im Besonderen die sehr großen Online-Plattformen (VLOPs) in die Verantwortung genommen, systemische Risiken, die unter anderem von Aktivitäten ausländischer Desinformationsakteure ausgehen, zu identifizieren und vorbeugende Maßnahmen zu ergreifen.